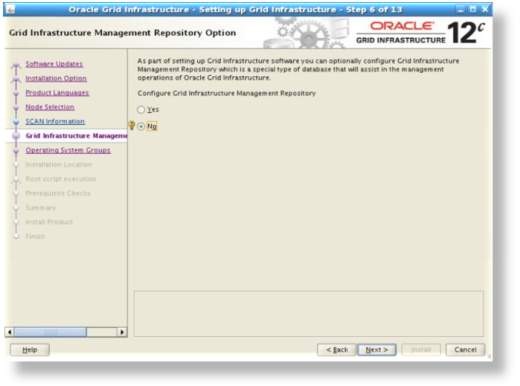

MGMTDB database, oracle 12c ile birlikte tanışmış olduğumuz databaselerden bir tanesi, oracle 12c RAC kurulumu ile bilirkte geliyor. Oracle 12.1.0.1 versiyonunda opsiyonel olan ve aşağıdaki ekranda YES seçilmesi sonrasında otomatik olan kurulunan MGMTDB database oracle 12.1.0.2 versiyonu ile birlikte zorunlu hale gelmiş olup, 12c RAC kurulumunda artık bu ekran gelmemektedir.

Management database, CHM (Cluster Health Monitor) ve diğer verileri, istatistiki verileri depolamak için merkezi ve veritabanı olarak tanımlanabilir.

Bu yazıda anlatacağım tüm testlerimi Oracle 12.1.0.2 versiyonu ile yaptım. Dolayısıyla bir karşılaştırma veya kıyaslama yapacaklar için bilgi olarak belirtmek istedim.

Kurulum sonrasındaki durum ;

[oragrid@Redhat702 ~]$ ps -ef|grep smon|grep -v grep

oragrid 1404 1 0 Jul21 ? 00:00:03 asm_smon_+ASM2

oragrid 2359 1 0 Jul21 ? 00:00:04 mdb_smon_-MGMTDB

oracle 2522 1 0 Jul21 ? 00:00:05 ora_smon_raccon12

root 9465 1 1 Jul15 ? 01:53:27 /u01/gi/oragrid/grid/12.1.0.2/bin/osysmond.bin

[oragrid@Redhat702 ~]$

Management instance sadece bir node üzerinde aktif olarak çalışmaktadır. Referance kısmında belirtmiş olduğum 1568402.1 id’ li dökümanda magament database ile ilgili temel bilgilere ulaşabilirsiniz. Ben özetle kısa bir bilgi vermeye çalışacağım merak edenler metalink üzerinden ilgili dökümana erişebilirler.

Mgmtdb database oracle 12c ile birlikte gelen ve cluster tarafında yönetilen bir single instance olduğunu söyleyebiliriz. Herhangi bir şekilde backup alınmasına ve tune edilmesine gerek yoktur. Cluster tarafından manage edildiği için herhangi bir şekilde üzerinde çalışan node’ un down olması durumunda otomatik olarak diğer node’ dan start edilir.

Management database shared storage üzerindeki OCR/Voting diskleri kullanır. Cluster resource’ larına baktığımız da aşağıdaki resourcelar GIMR’ ye ait olan resourcelardır.

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 |

[oracle@Redhat701 ~]$ crsctl stat res -t -------------------------------------------------------------------------------- Name Target State Server State details -------------------------------------------------------------------------------- Local Resources -------------------------------------------------------------------------------- ora.ARCH01_0000.dg ONLINE ONLINE Redhat701 STABLE ONLINE ONLINE Redhat702 STABLE ora.ASMNET1LSNR_ASM.lsnr ONLINE ONLINE Redhat701 STABLE ONLINE ONLINE Redhat702 STABLE ora.DATA01_0000.dg ONLINE ONLINE Redhat701 STABLE ONLINE ONLINE Redhat702 STABLE ora.DATA02_0000.dg ONLINE ONLINE Redhat701 STABLE ONLINE ONLINE Redhat702 STABLE ora.LISTENER.lsnr ONLINE ONLINE Redhat701 STABLE ONLINE ONLINE Redhat702 STABLE ora.net1.network ONLINE ONLINE Redhat701 STABLE ONLINE ONLINE Redhat702 STABLE ora.ons ONLINE ONLINE Redhat701 STABLE ONLINE ONLINE Redhat702 STABLE -------------------------------------------------------------------------------- Cluster Resources -------------------------------------------------------------------------------- ora.LISTENER_SCAN1.lsnr 1 ONLINE ONLINE Redhat701 STABLE ora.LISTENER_SCAN2.lsnr 1 ONLINE ONLINE Redhat702 STABLE ora.LISTENER_SCAN3.lsnr 1 ONLINE ONLINE Redhat702 STABLE ora.MGMTLSNR 1 ONLINE ONLINE Redhat701 169.254.179.100 10.10.10.201,STABLE ora.asm 1 ONLINE ONLINE Redhat701 Started,STABLE 2 ONLINE ONLINE Redhat702 STABLE 3 OFFLINE OFFLINE STABLE ora.cvu 1 ONLINE ONLINE Redhat702 STABLE ora.mgmtdb 1 ONLINE ONLINE Redhat701 Open,STABLE ora.oc4j 1 ONLINE ONLINE Redhat702 STABLE ora.raccon1.db 1 ONLINE ONLINE Redhat701 Open,STABLE 2 ONLINE ONLINE Redhat702 Open,STABLE ora.scan1.vip 1 ONLINE ONLINE Redhat701 STABLE ora.scan2.vip 1 ONLINE ONLINE Redhat702 STABLE ora.scan3.vip 1 ONLINE ONLINE Redhat702 STABLE ora.Redhat701.vip 1 ONLINE ONLINE Redhat701 STABLE ora.Redhat702.vip 1 ONLINE ONLINE Redhat702 STABLE -------------------------------------------------------------------------------- |

Operating system üzerindeki processlerini aşağıdaki şekilde baktığınız da görebilirsiniz ;

[oracle@Redhat701 ~]$ ps -ef| grep MGMTLSNR

oragrid 15684 1 0 11:15 ? 00:00:00 /u01/gi/oragrid/grid/12.1.0.2/bin/tnslsnr MGMTLSNR -no_crs_notify -inherit

[oracle@Redhat701 ~]$ ps -ef| grep pmon_-MGMTDB | grep -v grep

oragrid 18768 1 0 11:19 ? 00:00:01 mdb_pmon_-MGMTDB

GIMR database’ ini start etmek için;

srvctl start mgmtdb

stop etmek için ;

srvctl stop mgmtdb

statusunu check etmek için ;

srvctl status mgmtdb

Database is enabled

Instance -MGMTDB is running on node Redhat701

Database’ inin configurasyonlarını görmek için ;

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 |

[oragrid@Redhat701 ~]$ srvctl config mgmtdb Database unique name: _mgmtdb Database name: Oracle home: <CRS home> Oracle user: oragrid Spfile: +DATA01_0000/_MGMTDB/PARAMETERFILE/spfile.268.884342931 Password file: Domain: Start options: open Stop options: immediate Database role: PRIMARY Management policy: AUTOMATIC Type: Management PDB name: testrac_cluster PDB service: testrac_cluster Cluster name: testrac-cluster Database instance: -MGMTDB [oragrid@Redhat701 ~]$ |

Mgmmntdb’ nin hangi sunucu üzerinden çalıştığını sorgulamak için ;

[oragrid@Redhat701 ~]$ oclumon manage -get MASTER

Master = Redhat701

[oragrid@Redhat701 ~]$ oclumon manage -get alllogger -details

Logger = Redhat701

Nodes = Redhat701,Redhat702

Stop – start sonrasında cluster, database’in hangi node’ dan açacağına karar verecektir. Burdaki bir diğer önemli nokta database’ in ismi “-“ ile başladığından dolayı trace file’ leri açarken dosya isimlerinin başına “./” eklenmesidir. Deneyelim;

[oragrid@Redhat701 trace]$ pwd

/u01/app/oragrid/diag/rdbms/_mgmtdb/-MGMTDB/trace

[oragrid@Redhat701 trace]$ ls -lrt

-rw-r—– 1 oragrid oinstall 89 Jul 6 10:45 -MGMTDB_vktm_420.trm

-rw-r—– 1 oragrid oinstall 1223 Jul 6 10:45 -MGMTDB_vktm_420.trc

-rw-r—– 1 oragrid oinstall 71 Jul 6 10:45 -MGMTDB_vkrm_446.trm

-rw-r—– 1 oragrid oinstall 1093 Jul 6 10:45 -MGMTDB_vkrm_446.trc

-rw-r—– 1 oragrid oinstall 216 Jul 6 10:45 -MGMTDB_ora_389.trm

-rw-r—– 1 oragrid oinstall 5002 Jul 6 10:45 -MGMTDB_ora_389.trc

-rw-r—– 1 oragrid oinstall 71 Jul 6 10:45 -MGMTDB_lgwr_458.trm

-rw-r—– 1 oragrid oinstall 972 Jul 6 10:45 -MGMTDB_lgwr_458.trc

-rw-r—– 1 oragrid oinstall 118 Jul 6 10:45 -MGMTDB_ckpt_462.trm

-rw-r—– 1 oragrid oinstall 1150 Jul 6 10:45 -MGMTDB_ckpt_462.trc

Herhangi birini açmaya çalışalım ;

[oragrid@Redhat701 trace]$ more -MGMTDB_lg00_961.trc

more: unknown option “-M”

usage: more [-dflpcsu] [+linenum | +/pattern] name1 name2 …

hatasını alırız. Hata almamak için ;

[oragrid@Redhat701 trace]$ more ./-MGMTDB_lg00_961.trc

Trace file /u01/app/oragrid/diag/rdbms/_mgmtdb/-MGMTDB/trace/-MGMTDB_lg00_961.trc

Oracle Database 12c Enterprise Edition Release 12.1.0.2.0 – 64bit Production

With the Partitioning, Automatic Storage Management and Advanced Analytics options

ORACLE_HOME = /u01/gi/oragrid/grid/12.1.0.2

Sonuçta repository de olsa bir database’ den bahsettiğimiz için bu database’ inde bir takım file’ leri olacaktır. Bunlarda default olarak OCR/Voting disklerin bulunduğu lokasyon ile aynı lokasyonda tutulmaktadır. Kontrol etmek adına öncelikle ocr file’ lerimizin nerde olduğuna bakalım ;

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 |

[oragrid@Redhat701 ~]$ ocrcheck Status of Oracle Cluster Registry is as follows : Version : 4 Total space (kbytes) : 409568 Used space (kbytes) : 1716 Available space (kbytes) : 407852 ID : 79450925 Device/File Name : +DATA01_0000 Device/File integrity check succeeded Device/File not configured Device/File not configured Device/File not configured Device/File not configured Cluster registry integrity check succeeded Logical corruption check succeeded [oragrid@Redhat701 ~]$ |

Ocr file’ lerimzi +DATA01_0000 altındaymış şimdi mgmtdbdb’ nin file’ leri nerde ona bakalım;

[oragrid@Redhat701 ~]$ oclumon manage -get reppath

CHM Repository Path = +DATA01_0000/_MGMTDB/FD9B43BF6A646F8CE043B6A9E80A2815/DATAFILE/sysmgmtdata.269.884343075

Aynı diskgroup içerisinde olduğunu burdan da görebilirsiniz.

Cluster Health Monitor ile ilgilide kısa bir bilgi verelim, default olarak Grid infrastructure içerisinde store edilen ve cluster içerisindeki node başına 1 gb’ lık bir alana gereksinim duymaktadır. Default olarak gelen bu değerler (path ve lokasyon) sonrasında oclumon tool’ u yardımıyla update edilebilmektedir. CHM operating system tarafında da bir takım loglar topladığı için burada toplanan loglanan retentitonınıda ihtiyaca göre set etmek gerekmektedir. Buradaki size kullananılan node başına ve saklanması planlanan saat başına farklılık gösterecektir. Bu size’ ın nasıl hesaplanması gerektiği ile ilgili metalinkde 1921105.1 id’ li dökümana bakabilirsiniz. Ben komutların klasik olarak nasıl kullanılabileceğini göstermek adına sadece birkaç örnek paylaşıyor olacağım.

Şu anki repository’ nin retentition’ ını görmek için ;

[oragrid@Redhat701 ~]$ oclumon manage -get repsize

CHM Repository Size = 136320 seconds

Retentition’ ını deiştirmek için (288000 olarak değiştiriyorum – 80 saat)

[oragrid@Redhat701 ~]$ oclumon manage -repos checkretentiontime 288000

The Cluster Health Monitor repository is too small for the desired retention. Please first resize the repository to 4329 MB

Değiştirmek istediğimde bu değişikliği yapmadan önce respository’ in size’ ını değiştirmek (artırmak) gerektiğini belirtiyor. Yapalım ;

[oragrid@Redhat701 ~]$ oclumon manage -repos changerepossize 4329

The Cluster Health Monitor repository was successfully resized.The new retention is 288060 seconds.

[oragrid@Redhat701 ~]$ oclumon manage -repos checkretentiontime 288000

The Cluster Health Monitor repository can support the desired retention for 2 hosts

[oragrid@Redhat701 ~]$

Repository’ in size’ ınıda 4329’ a çektiğimiz de retentitionında bizim belirttiğimiz değere denk geldiğini gördük.

Cluster Health Monitor servisi iki kısımdan oluşur;

• System Monitor Service, her bir node üzerinde çalışan bir servistir. Bu servis operating system metriclerini toplayarak cluster logger servisine gönderir.

[oragrid@Redhat701 ~]$ ps -ef | grep osysmond

root 9528 1 0 Jul15 ? 02:19:20 /u01/gi/oragrid/grid/12.1.0.2/bin/osysmond.bin

[oragrid@Redhat701 ~]$ ps -ef | grep olog

root 17379 1 0 Jul21 ? 00:48:45 /u01/gi/oragrid/grid/12.1.0.2/bin/ologgerd -M -d /u01/gi/oragrid/grid/12.1.0.2/crf/db/Redhat701

• Cluster logger service, sadece tek bir node üzerinde çalışan bir servistir. Cluster logger servisi eğer master olarak çalıştığı node üzerinde down olması durumunda cluster servisi tarafından seçilen bir diğer node üzerinden çalışmaya devam eder. Cluster logger servisi, CHM içerisindeki operating system metriclerini yönetir.

[oragrid@Redhat702 ~]$ ps -ef|grep osysmond

root 9465 1 1 Jul15 ? 02:53:08 /u01/gi/oragrid/grid/12.1.0.2/bin/osysmond.bin

[oragrid@Redhat702 ~]$ ps -ef|grep olog

oragrid 7810 7725 0 13:22 pts/0 00:00:00 grep olog

Yukarıda da belirttiğim üzere Oclumon tool’ u ile CHM’ i yönetebiliriz.

Oclumon tool’ u ile ilgili sık kullanılan komutlardan biriside oclumon dumpnodeview komutu diye düşünüyorum. Bo komutun kullanımı ve neyi gösterdiği ile ilgilide çok ufak bir bilgi vermek istiyorum. Node’ lar üzerindeki günlük bilgileri, logları monitor etmek için bu komutu kullanabiliriz. CHM ile node ‘ lar üzerinden her saniye de bir belirlenen metricler doğrultusunda log toplanmaktadır. Komutun kullanımı ile ilgili;

Syntax ;

oclumon dumpnodeview [[-allnodes] | [-n node1 node2] [-last “duration”] |

[-s “time_stamp” -e “time_stamp”] [-v] [-warning]] [-h]

Tüm node’ lardaki logları anlık olarak izlemek istersek (aşağıdaki komut ile tüm node ‘lar daki loglar 5 sn aralıklarla sırası ile ekrana yansıyacaktır) ;

[oragrid@Redhat702 ~]$ oclumon dumpnodeview -allnodes

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 |

[oragrid@Redhat702 ~]$ oclumon dumpnodeview -allnodes ---------------------------------------- Node: Redhat701 Clock: '15-07-27 14.12.43 Europe/Istanbul' SerialNo:207062 ---------------------------------------- SYSTEM: #pcpus: 2 #vcpus: 4 cpuht: N chipname: Intel(R) cpu: 2.64 cpuq: 0 physmemfree: 4728224 physmemtotal: 16205180 mcache: 8562184 swapfree: 16777212 swaptotal: 16777212 hugepagetotal: 0 hugepagefree: 0 hugepagesize: 2048 ior: 161 iow: 282 ios: 54 swpin: 0 swpout: 0 pgin: 80 pgout: 103 netr: 67.904 netw: 72.721 procs: 386 procsoncpu: 1 rtprocs: 23 rtprocsoncpu: N/A #fds: 35392 #sysfdlimit: 6815744 #disks: 23 #nics: 3 nicErrors: 0 TOP CONSUMERS: topcpu: 'ora_vktm_raccon(19742) 1.79' topprivmem: 'java(1884) 311640' topshm: 'ora_mman_raccon(19759) 802028' topfd: 'java(1884) 307' topthread: 'crsd.bin(17358) 40' ---------------------------------------- Node: Redhat701 Clock: '15-07-27 14.12.48 Europe/Istanbul' SerialNo:207063 ---------------------------------------- SYSTEM: #pcpus: 2 #vcpus: 4 cpuht: N chipname: Intel(R) cpu: 13.47 cpuq: 0 physmemfree: 4717748 physmemtotal: 16205180 mcache: 8562196 swapfree: 16777212 swaptotal: 16777212 hugepagetotal: 0 hugepagefree: 0 hugepagesize: 2048 ior: 1260 iow: 430 ios: 186 swpin: 0 swpout: 0 pgin: 652 pgout: 155 netr: 96.703 netw: 70.282 procs: 386 procsoncpu: 2 rtprocs: 23 rtprocsoncpu: N/A #fds: 35712 #sysfdlimit: 6815744 #disks: 23 #nics: 3 nicErrors: 0 TOP CONSUMERS: topcpu: 'asm_vktm_+asm1(18945) 1.79' topprivmem: 'java(1884) 311640' topshm: 'ora_mman_raccon(19759) 802028' topfd: 'java(1884) 309' topthread: 'crsd.bin(17358) 40' ---------------------------------------- Node: Redhat702 Clock: '15-07-27 14.12.44 Europe/Istanbul' SerialNo:207065 ---------------------------------------- SYSTEM: #pcpus: 2 #vcpus: 4 cpuht: N chipname: Intel(R) cpu: 2.90 cpuq: 0 physmemfree: 5462868 physmemtotal: 16205180 mcache: 7874828 swapfree: 16777212 swaptotal: 16777212 hugepagetotal: 0 hugepagefree: 0 hugepagesize: 2048 ior: 85 iow: 1767 ios: 259 swpin: 0 swpout: 0 pgin: 42 pgout: 455 netr: 55.893 netw: 41.817 procs: 346 procsoncpu: 2 rtprocs: 21 rtprocsoncpu: N/A #fds: 34144 #sysfdlimit: 6815744 #disks: 23 #nics: 3 nicErrors: 0 TOP CONSUMERS: topcpu: 'crsd.bin(1540) 2.19' topprivmem: 'java(1883) 309620' topshm: 'ora_mman_raccon(2386) 819492' topfd: 'java(1883) 547' topthread: 'crsd.bin(1540) 42' ---------------------------------------- Node: Redhat702 Clock: '15-07-27 14.12.49 Europe/Istanbul' SerialNo:207066 ---------------------------------------- SYSTEM: #pcpus: 2 #vcpus: 4 cpuht: N chipname: Intel(R) cpu: 4.19 cpuq: 0 physmemfree: 5453696 physmemtotal: 16205180 mcache: 7874864 swapfree: 16777212 swaptotal: 16777212 hugepagetotal: 0 hugepagefree: 0 hugepagesize: 2048 ior: 136 iow: 277 ios: 65 swpin: 0 swpout: 0 pgin: 68 pgout: 82 netr: 72.787 netw: 73.421 procs: 346 procsoncpu: 1 rtprocs: 21 rtprocsoncpu: N/A #fds: 34240 #sysfdlimit: 6815744 #disks: 23 #nics: 3 nicErrors: 0 TOP CONSUMERS: topcpu: 'gipcd.bin(8555) 1.60' topprivmem: 'java(1883) 309620' topshm: 'ora_mman_raccon(2386) 819492' topfd: 'java(1883) 549' topthread: 'crsd.bin(1540) 42' |

Sadece tek bir node’ daki logları gözlemlemek istersek ;

|

1 2 3 4 5 6 7 8 9 10 11 |

[oragrid@Redhat702 ~]$ oclumon dumpnodeview -n Redhat701 ---------------------------------------- Node: Redhat701 Clock: '15-07-27 14.16.53 Europe/Istanbul' SerialNo:207112 ---------------------------------------- SYSTEM: #pcpus: 2 #vcpus: 4 cpuht: N chipname: Intel(R) cpu: 8.35 cpuq: 0 physmemfree: 4742828 physmemtotal: 16205180 mcache: 8562680 swapfree: 16777212 swaptotal: 16777212 hugepagetotal: 0 hugepagefree: 0 hugepagesize: 2048 ior: 162 iow: 320 ios: 71 swpin: 0 swpout: 0 pgin: 81 pgout: 106 netr: 48.359 netw: 73.301 procs: 381 procsoncpu: 1 rtprocs: 23 rtprocsoncpu: N/A #fds: 34560 #sysfdlimit: 6815744 #disks: 23 #nics: 3 nicErrors: 0 TOP CONSUMERS: topcpu: 'asm_vktm_+asm1(18945) 1.99' topprivmem: 'java(1884) 311640' topshm: 'ora_mman_raccon(19759) 802028' topfd: 'oraagent.bin(17837) 246' topthread: 'crsd.bin(17358) 40' |

Herhangi bir node’ da veya tüm node’ larda belirli bir zaman aralığını görmek istersek ;

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 |

[oragrid@Redhat702 ~]$ oclumon dumpnodeview -allnodes -last "14:00:00" ---------------------------------------- Node: Redhat701 Clock: '15-07-27 00.18.55 Europe/Istanbul' SerialNo:197059 ---------------------------------------- SYSTEM: #pcpus: 2 #vcpus: 4 cpuht: N chipname: Intel(R) cpu: 1.76 cpuq: 0 physmemfree: 4928808 physmemtotal: 16205180 mcache: 8395452 swapfree: 16777212 swaptotal: 16777212 hugepagetotal: 0 hugepagefree: 0 hugepagesize: 2048 ior: 213 iow: 282 ios: 65 swpin: 0 swpout: 0 pgin: 106 pgout: 97 netr: 47.647 netw: 64.563 procs: 375 procsoncpu: 1 rtprocs: 23 rtprocsoncpu: N/A #fds: 34432 #sysfdlimit: 6815744 #disks: 23 #nics: 3 nicErrors: 0 TOP CONSUMERS: topcpu: 'mdb_vktm_-mgmtd(18781) 1.19' topprivmem: 'java(1884) 311580' topshm: 'ora_mman_raccon(19759) 802028' topfd: 'java(1884) 451' topthread: 'crsd.bin(17358) 40' ---------------------------------------- Node: Redhat701 Clock: '15-07-27 00.19.00 Europe/Istanbul' SerialNo:197060 ---------------------------------------- SYSTEM: #pcpus: 2 #vcpus: 4 cpuht: N chipname: Intel(R) cpu: 2.01 cpuq: 0 physmemfree: 4929192 physmemtotal: 16205180 mcache: 8395472 swapfree: 16777212 swaptotal: 16777212 hugepagetotal: 0 hugepagefree: 0 hugepagesize: 2048 ior: 110 iow: 385 ios: 75 swpin: 0 swpout: 0 pgin: 55 pgout: 126 netr: 38.417 netw: 47.446 procs: 375 procsoncpu: 1 rtprocs: 23 rtprocsoncpu: N/A #fds: 34464 #sysfdlimit: 6815744 #disks: 23 #nics: 3 nicErrors: 0 TOP CONSUMERS: topcpu: 'gipcd.bin(8734) 1.40' topprivmem: 'java(1884) 311580' topshm: 'ora_mman_raccon(19759) 802028' topfd: 'java(1884) 455' topthread: 'crsd.bin(17358) 40' ---------------------------------------- Node: Redhat701 Clock: '15-07-27 00.19.05 Europe/Istanbul' SerialNo:197061 ---------------------------------------- SYSTEM: #pcpus: 2 #vcpus: 4 cpuht: N chipname: Intel(R) cpu: 1.76 cpuq: 0 physmemfree: 4928820 physmemtotal: 16205180 mcache: 8395472 swapfree: 16777212 swaptotal: 16777212 hugepagetotal: 0 hugepagefree: 0 hugepagesize: 2048 ior: 213 iow: 279 ios: 62 swpin: 0 swpout: 0 pgin: 106 pgout: 100 netr: 59.354 netw: 72.566 procs: 375 procsoncpu: 2 rtprocs: 23 rtprocsoncpu: N/A #fds: 34400 #sysfdlimit: 6815744 #disks: 23 #nics: 3 nicErrors: 0 TOP CONSUMERS: topcpu: 'asm_vktm_+asm1(18945) 1.39' topprivmem: 'java(1884) 311580' topshm: 'ora_mman_raccon(19759) 802028' topfd: 'java(1884) 457' topthread: 'crsd.bin(17358) 40' |

Reference ;

FAQ: 12c Grid Infrastructure Management Repository (GIMR) (Doc ID 1568402.1)

_mgmtdb Service Registered with All Local Listeners in a Grid Infrastructure Environment (Doc ID 1945558.1)

How to Move/Recreate GI Management Repository to Different Shared Storage (Diskgroup, CFS or NFS etc) (Doc ID 1589394.1)

Managing the Cluster Health Monitor Repository (Doc ID 1921105.1)